今や私たちの生活に欠かせないAI(人工知能)。しかし、その「知能」を物理的に動かしているチップのことは、あまり知られていません。ニュースでよく聞くGPU、そして最近話題のNPUやTPU。これらは一体何が違うのでしょうか? 今回は、AIを支えるこれら3つのプロセッサの役割と、未来を変えるチームワークについて解説します。

【導入:プロローグ】

はじめに:AI時代の「頭脳」は一つではない

かつてコンピュータの頭脳といえば、CPU(中央演算処理装置)が唯一無二の存在でした。しかし、AI技術が爆発的に進化した現代において、CPUだけで全ての処理を行うことは、もはや不可能です。膨大なデータを読み込み、複雑なパターンを学習するには、従来のやり方では時間がかかりすぎるのです。

そこで登場したのが、GPU、TPU、NPUといった新しい頭脳たちです。これらが並ぶと、「結局どれが一番性能が良いのか?」「どれが最強なのか?」という議論になりがちです。しかし、それは大きな誤解です。

彼らは互いにライバルとして競い合っているのではなく、それぞれが全く異なる得意分野を持っています。例えるなら、彼らはオーケストラの一員です。指揮者がいて、弦楽器があり、打楽器があるように、それぞれのプロセッサが適材適所で能力を発揮することで、初めてAIという美しい交響曲を奏でることができるのです。本稿では、この「最強のチームワーク」の秘密を解き明かします。

【第1章:司令塔の役割】

1. 汎用性の王者「CPU」の役割を再定義する

AIチップの話をする前に、まずは基本となるCPUの役割を正しく理解する必要があります。

なぜCPUは「汎用的」なのか

CPUは、コンピュータにおける「万能選手」であり、オーケストラで言えば「指揮者」です。OS(基本ソフト)を動かし、アプリを起動し、キーボードの入力を受け付けるといった多種多様な作業を、一つずつ順番に、しかし極めて高速に処理することを得意としています。 CPUの凄さは、どんな命令が来ても対応できる「判断力」と「複雑な処理能力」にあります。「もしAならBをする、そうでなければCをする」といった複雑な分岐条件が含まれるプログラムを処理させれば、CPUの右に出るものはいません。

AI処理におけるCPUの限界と、これからの役割

しかし、この「一つずつ丁寧に処理する」という性質が、AIにおいては弱点となります。AI、特にディープラーニングの計算は、単純な計算を何億回も同時に行う必要があるからです。指揮者が一人ですべての楽器を演奏できないのと同様に、CPU一人で膨大なデータを処理しようとするとパンクしてしまいます。

だからといって、CPUが不要になるわけではありません。GPUやNPUといったスペシャリストたちに「君はこのデータを処理して」「次は君の出番だ」と的確に指示を出し、全体のデータを管理する司令塔としての役割は、これまで以上に重要になっているのです。

【第2章:3つのプロセッサの個性】

2. AIを加速させる3つのスペシャリストたち

CPUという司令塔のもとで、実際にAIの計算という重労働を担う3つのスペシャリスト、GPU・TPU・NPUについて、その個性を深掘りしていきましょう。

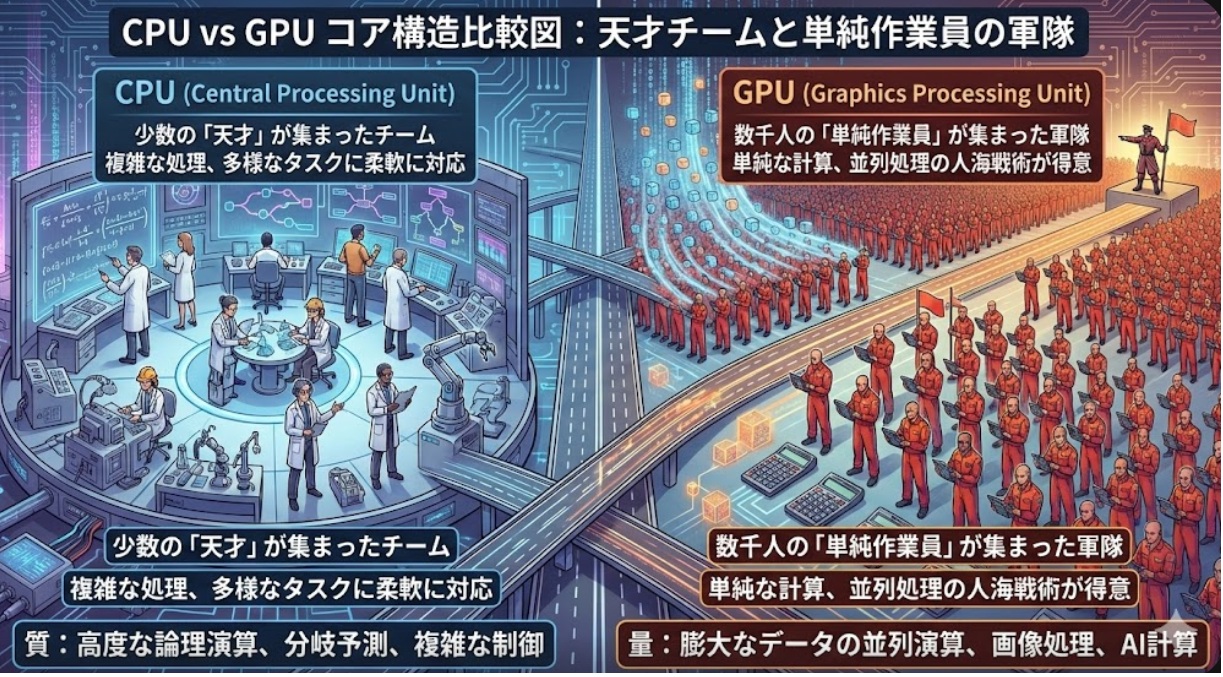

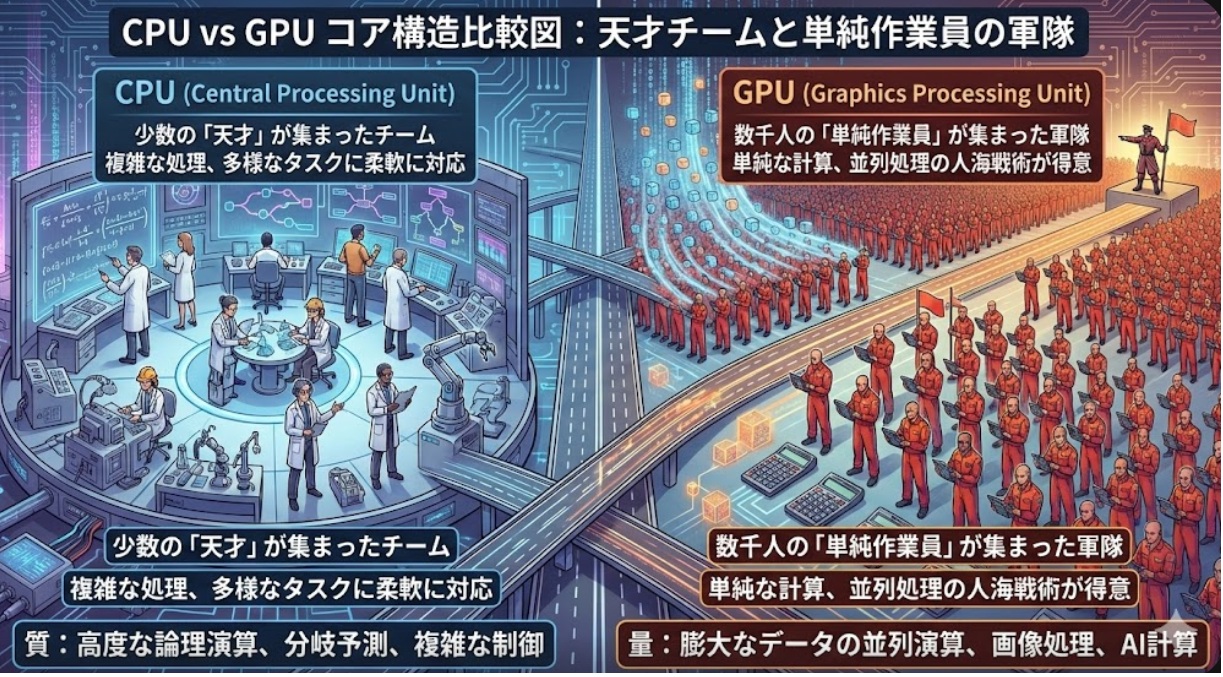

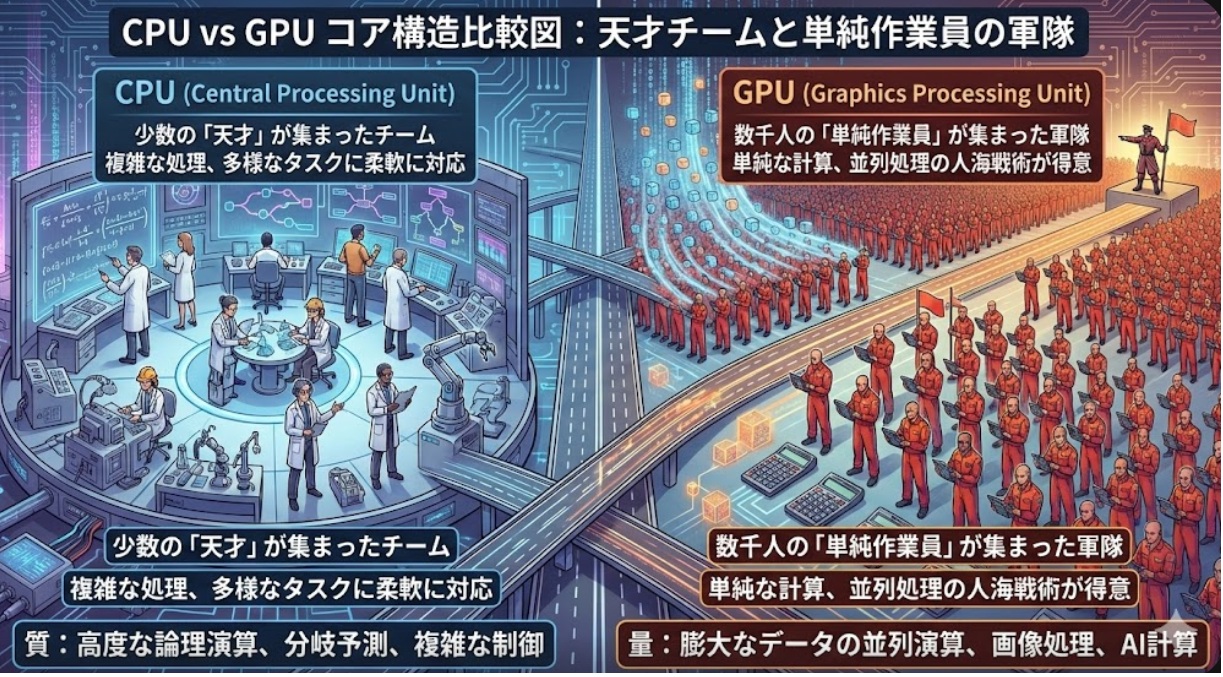

図. CPUとGPUのコア構造比較図

2-1. GPU (Graphics Processing Unit):並列処理の怪力

画像処理からAIへ:歴史的転換点 もともとGPUは、その名の通り「グラフィックス(画像)」を描画するためのチップでした。3Dゲームの映像などを滑らかに動かすために開発されたものです。画面上の何百万という「点(ピクセル)」の色を同時に計算して塗り替える作業は、単純な計算の超高速な繰り返しです。 ある時、研究者たちは気づきました。「この『単純な計算を同時に大量に行う』能力は、AIの計算そのものではないか?」と。これが歴史的な転換点となり、GPUは映像用チップから、AI計算の主役へと躍り出た...

今や私たちの生活に欠かせないAI(人工知能)。しかし、その「知能」を物理的に動かしているチップのことは、あまり知られていません。ニュースでよく聞くGPU、そして最近話題のNPUやTPU。これらは一体何が違うのでしょうか? 今回は、AIを支えるこれら3つのプロセッサの役割と、未来を変えるチームワークについて解説します。

【導入:プロローグ】

はじめに:AI時代の「頭脳」は一つではない

かつてコンピュータの頭脳といえば、CPU(中央演算処理装置)が唯一無二の存在でした。しかし、AI技術が爆発的に進化した現代において、CPUだけで全ての処理を行うことは、もはや不可能です。膨大なデータを読み込み、複雑なパターンを学習するには、従来のやり方では時間がかかりすぎるのです。

そこで登場したのが、GPU、TPU、NPUといった新しい頭脳たちです。これらが並ぶと、「結局どれが一番性能が良いのか?」「どれが最強なのか?」という議論になりがちです。しかし、それは大きな誤解です。

彼らは互いにライバルとして競い合っているのではなく、それぞれが全く異なる得意分野を持っています。例えるなら、彼らはオーケストラの一員です。指揮者がいて、弦楽器があり、打楽器があるように、それぞれのプロセッサが適材適所で能力を発揮することで、初めてAIという美しい交響曲を奏でることができるのです。本稿では、この「最強のチームワーク」の秘密を解き明かします。

【第1章:司令塔の役割】

1. 汎用性の王者「CPU」の役割を再定義する

AIチップの話をする前に、まずは基本となるCPUの役割を正しく理解する必要があります。

なぜCPUは「汎用的」なのか

CPUは、コンピュータにおける「万能選手」であり、オーケストラで言えば「指揮者」です。OS(基本ソフト)を動かし、アプリを起動し、キーボードの入力を受け付けるといった多種多様な作業を、一つずつ順番に、しかし極めて高速に処理することを得意としています。 CPUの凄さは、どんな命令が来ても対応できる「判断力」と「複雑な処理能力」にあります。「もしAならBをする、そうでなければCをする」といった複雑な分岐条件が含まれるプログラムを処理させれば、CPUの右に出るものはいません。

AI処理におけるCPUの限界と、これからの役割

しかし、この「一つずつ丁寧に処理する」という性質が、AIにおいては弱点となります。AI、特にディープラーニングの計算は、単純な計算を何億回も同時に行う必要があるからです。指揮者が一人ですべての楽器を演奏できないのと同様に、CPU一人で膨大なデータを処理しようとするとパンクしてしまいます。

だからといって、CPUが不要になるわけではありません。GPUやNPUといったスペシャリストたちに「君はこのデータを処理して」「次は君の出番だ」と的確に指示を出し、全体のデータを管理する司令塔としての役割は、これまで以上に重要になっているのです。

【第2章:3つのプロセッサの個性】

2. AIを加速させる3つのスペシャリストたち

CPUという司令塔のもとで、実際にAIの計算という重労働を担う3つのスペシャリスト、GPU・TPU・NPUについて、その個性を深掘りしていきましょう。

図. CPUとGPUのコア構造比較図

2-1. GPU (Graphics Processing Unit):並列処理の怪力

画像処理からAIへ:歴史的転換点 もともとGPUは、その名の通り「グラフィックス(画像)」を描画するためのチップでした。3Dゲームの映像などを滑らかに動かすために開発されたものです。画面上の何百万という「点(ピクセル)」の色を同時に計算して塗り替える作業は、単純な計算の超高速な繰り返しです。 ある時、研究者たちは気づきました。「この『単純な計算を同時に大量に行う』能力は、AIの計算そのものではないか?」と。これが歴史的な転換点となり、GPUは映像用チップから、AI計算の主役へと躍り出たのです。

得意分野:大量のデータを一気に処理する「学習」フェーズ GPUの最大の武器は「並列処理」です。CPUが数個の高性能なコアで順序よく仕事をするのに対し、GPUは数千個の小さなコアで一気に人海戦術を行います。 この能力は、AI開発における「学習(トレーニング)」というフェーズで真価を発揮します。教科書となる膨大なデータを読み込ませ、AIモデルを作り上げていく作業には、圧倒的な計算量が必要です。この重労働をこなせるのは、現状ではGPUの怪力しかありません。

代表的な活用例 今話題の「大規模言語モデル(LLM)」などの生成AIを作るには、数千、数万個のGPUを連結させたスーパーコンピュータが必要です。もちろん、本来の役割である高度な3Dグラフィックスや動画編集でも活躍し続けています。

2-2. TPU (Tensor Processing Unit):Googleが生んだAI特化型

テンソル計算への徹底的な最適化 、TPUは、Googleが自社のAIサービスを高速化するために独自開発したプロセッサです。名前にある「テンソル」とは、AI計算で使われるデータのまとまりのことだと考えてください。 GPUは「画像処理」から「AI」へ転用されましたが、TPUは最初から「AIの計算(行列演算)」だけをひたすら高速に行うために設計されています。余計な機能を一切削ぎ落とし、AI計算に必要な回路だけをぎっしりと詰め込んでいます。

得意分野:Google系サービスでの超高速処理、電力効率 特定の計算に特化しているため、その処理における速度と電力効率は圧倒的です。検索エンジンの順位付け、翻訳機能、音声認識など、Googleの巨大なサービスを支える裏側で、TPUは24時間稼働しています。

CPU・GPUとの決定的な違い、 TPUの強みは「特化しすぎていること」ですが、それは同時に弱点でもあります。GPUのように汎用的な計算には向いていませんし、誰でも手軽に買ってきて自宅のPCに挿せるものでもありません(主にクラウド経由で利用します)。「特定のルールの下では世界最強だが、ルールが変わると脆い」という、職人気質のプロセッサと言えるでしょう。

2-3. NPU (Neural Processing Unit):エッジで輝く省エネの星

私たちの手元(スマホ・PC)にあるAIチップ、 最近のスマートフォンやノートPCのスペック表でよく見かけるようになったのがNPUです。例えば、iPhoneに搭載されている「Neural Engine」や、最新のWindows PC(AI PC)に搭載されているインテルのNPUなどがこれに当たります。メーカーによっては「Neural Engine」や「AIエンジン」と呼ばれることもあります。 GPUやTPUが巨大なデータセンターで「学習」を行うのに対し、NPUは私たちの手元のデバイス(エッジ)で働くことに特化しています。

得意分野:学習済みモデルを動かす「推論」フェーズ NPUの主な仕事は「推論」です。これは、GPUなどが時間をかけて学習した「完成したAIモデル」を使って、実際に答えを出す作業のことです。例えば、スマホのカメラで撮影した瞬間に「これは猫だ」と認識したり、リアルタイムで外国語を翻訳したりする処理です。

なぜNPUが必要なのか、 これまでこうした処理はクラウド(サーバー)に送って行っていましたが、通信の遅延やプライバシーの問題がありました。NPUがあれば、インターネットに繋がなくても、端末の中で瞬時にAIを動かせます。しかも、NPUはバッテリー消費を最小限に抑えるように設計されているため、スマホの電池を長持ちさせながら高度なAI機能を使うことができるのです。

【第3章:比較と連携】

3. 競合ではなく「適材適所」:違いを整理する

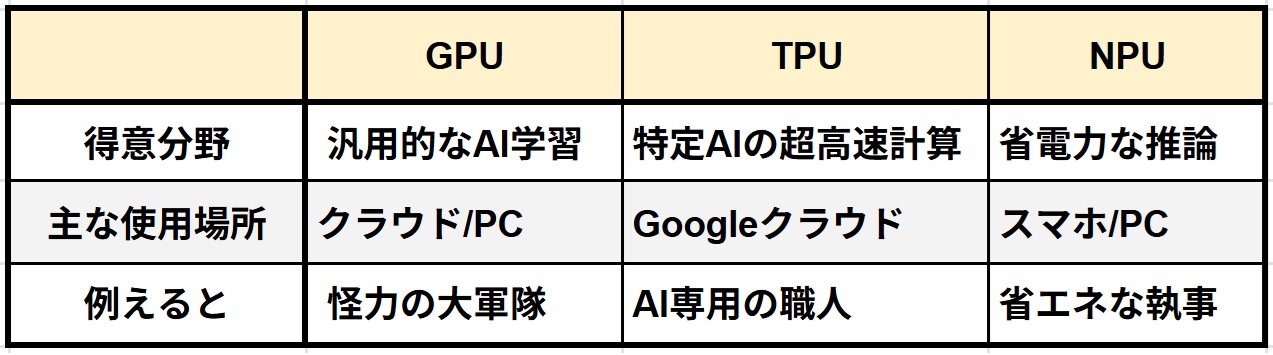

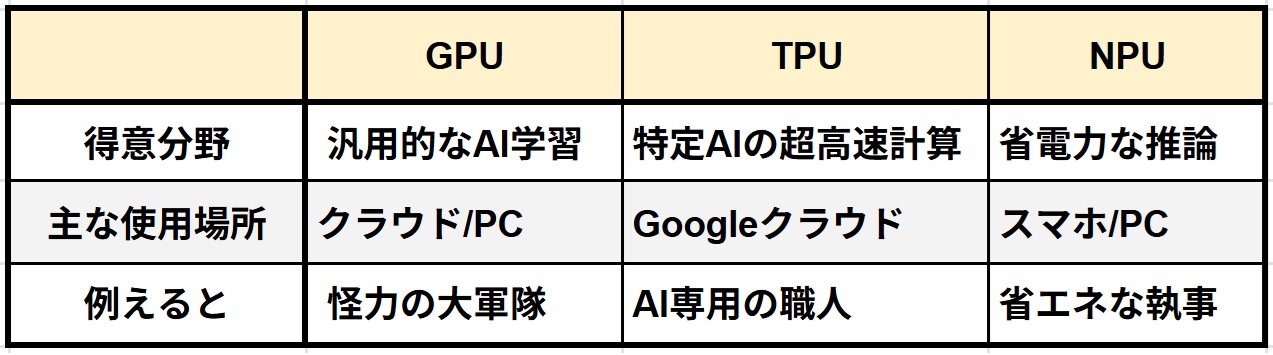

ここまで見てきたように、3つのプロセッサはそれぞれ異なる「性格」を持っています。これらを整理し、どのように連携しているのかを見てみましょう。3つのプロセッサの違いをまとめたのが以下の表です。

表. プロセッサ(GPU・TPU・NPU)の違い

比較分析: 処理能力 vs 電力効率 vs 汎用性 まず、GPUは「パワー重視」です。消費電力は大きいですが、圧倒的な計算力でAIを作り上げます。次にTPUは「特定特化」です。特定のAI計算において最高の効率を叩き出します。そしてNPUは「効率重視」です。限られた電力の中で、素早くAIを実行することに長けています。そして、これら全体を管理するのが「汎用性」の塊であるCPUです。

ヘテロジニアス・コンピューティングの世界、 現在のコンピュータは、これらを組み合わせて使う「ヘテロジニアス(異種混合)・コンピューティング」が主流です。これは、「適材適所」をハードウェアレベルで実現する考え方です。一つのチップの中に、CPU、GPU、NPUの各エリアがあり、作業内容によって瞬時に担当を切り替えています。

CPUが指示し、GPUが学習し、NPUが実行する 具体的な連携フローを見てみましょう。 例えば、新しい音声認識AIを作るとします。

クラウド(GPU)で勉強 → モデル完成 → スマホ(NPU)で実践

この流れを「学習と推論の分業」と呼びます。

クラウド(データセンター): まず、数万時間分の音声データをCPUが整理し、GPU(またはTPU)に渡します。GPUはその怪力を使って、何日もかけて「言葉のパターン」を学習し、AIモデルを完成させます。

私たちの手元(スマホ): 完成したAIモデルは、アップデートとしてスマホに配信されます。あなたがスマホに話しかけた瞬間、スマホ内のCPUが「これは音声認識の仕事だ」と判断し、NPUに処理を投げます。NPUは省電力で即座に音声を文字に変換し、結果をCPUに返します。

このように、学習という「準備」はGPUが、推論という「実戦」はNPUが担当し、それらをCPUが繋ぐことで、私たちはストレスなくAIの恩恵を受けられるのです。

【第4章:未来展望】

4. 今後どのように進化・発展していくのか

このプロセッサたちの進化は、今後どのように進んでいくのでしょうか。

プロセッサの融合(SoCの進化)、 一つの大きな流れは「融合」です。すでにスマートフォンでは当たり前になっていますが、CPU、GPU、NPUを一つのチップに統合した「SoC(システム・オン・チップ)」の技術が、パソコンやサーバー分野でも加速しています。チップ間のデータのやり取りが内部で完結するため、処理速度が上がり、消費電力も劇的に下がります。まるで、それぞれの専門家が同じ部屋で机を並べて仕事をするような効率の良さが実現されつつあります。

AIの「民主化」を支えるハードウェアの低コスト化・省電力化

ハードウェアの進化は、AIの「民主化」を推し進めます。かつてはスーパーコンピュータでしか動かなかったAIが、NPUの進化によって安価なパソコンやスマホでも動くようになります。これにより、誰もが自分の端末で、自分だけの専用AIアシスタントを持つ時代がすぐそこまで来ています。

次世代の課題:ムーアの法則の限界と新たなアーキテクチャへの挑戦 一方で課題もあります。「半導体の性能は18ヶ月で2倍になる」という「ムーアの法則」が限界を迎えつつあると言われています。回路を微細化すること物理的に難しくなっているのです。 そのため、単に細かくするだけでなく、チップを立体的に積み重ねたり、光を使って信号を伝達したりする新しいアーキテクチャへの挑戦が始まっています。これらが実用化されれば、今の常識を覆すような、さらに人間に近い判断ができるAIチップが誕生するかもしれません。

【結び:エピローグ】

おわりに:進化し続ける「知能」の基盤

AIというと、どうしてもソフトウェアやアルゴリズムといった「目に見えない部分」に注目が集まりがちです。しかし、その革新的なソフトウェアを動かしているのは、紛れもなく物理的な半導体チップたちです。

汎用性を極めたCPU、並列処理の巨人GPU、Googleの知恵TPU、そして身近な省エネ名手NPU。彼らは決して「どれが一番か」を争っているのではなく、それぞれの持ち場を守りながら、全体として最高のパフォーマンスを発揮しています。

ハードウェアの進化なくして、AIの発展はありません。この「シリコンのチームワーク」が今後さらに洗練され、融合していくことで、人間とAIがより自然に、より高度に共存する未来が切り拓かれていくことでしょう。私たちが手にするデバイスの中で、今この瞬間も、彼らは静かに、しかし熱く協奏曲を奏で続けているのです。

◆連載記事紹介:ものづくりドットコムの人気連載記事をまとめたページはこちら!