今、ビジネスの現場では「AIを使わない」という選択肢が消えつつあります。業務効率化から新規事業の創出まで、AIは企業の成長エンジンそのものになり得るからです。しかし、強力なエンジンには、それを制御する高度なハンドルとブレーキが必要です。それが「AIガバナンス」です。今回は、AI活用を単なるブームで終わらせず、企業が永続的に成長するための生存戦略として、ガバナンスの構築から最新の法規制対応までを網羅的に解説します。

序文:AIの進化と「待ったなし」の課題

1. 生成AIの爆発的普及と社会へのインパクト

かつてSFの世界の話であった人工知能(AI)は、ディープラーニングの進化を経て、今や私たちの日常業務に深く浸透しました。特に2022年以降の生成AI(Generative AI)の登場は、産業革命にも匹敵するパラダイムシフトをもたらしています。 これまでのAIがデータの「分析・分類」を得意としていたのに対し、生成AIは文章、画像、プログラムコードなど、新しい価値を「創造」することができます。これにより、マーケティング資料の作成、顧客対応の自動化、新製品のアイデア出しなど、ホワイトカラーの業務領域において劇的な生産性向上が実現しつつあります。企業にとってAI活用は、もはや「あれば便利」なツールではなく、競争力を左右する「経営資源」そのものとなったのです。

2. 利便性の裏に潜むリスク

しかし、光が強ければ影もまた濃くなります。AIの急速な普及は、企業に予期せぬリスクをもたらしました。 最も代表的なのが「ハルシネーション(幻覚)」と呼ばれる現象です。AIがもっともらしい嘘をつくこの現象は、誤った経営判断や顧客への誤情報の提供につながる恐れがあります。 また、学習データに含まれる偏見がAIに継承されることによる「差別」の問題も深刻です。採用AIが特定の人種や性別を不利に扱ったり、融資審査で不当な判定を下したりする事例は、世界中で報告されています。 さらに、生成AIが既存の著作物を学習・出力することによる「著作権侵害」のリスクや、機密情報がAIを通じて外部に流出するセキュリティリスクも無視できません。これらは単なる技術的なエラーではなく、企業の社会的信用を一瞬で失墜させる経営リスクなのです。

3. リスクを制御し、AIの価値を最大化する道筋を示す

これらのリスクを恐れてAIの利用を禁止することは、企業の成長機会を放棄することと同義です。重要なのは、リスクをゼロにすることではなく、許容可能な範囲にコントロールしながら、AIの価値を最大化することです。 本稿では、AIのリスクを適切に管理し、社会から信頼される企業となるための枠組みである「AIガバナンス」について詳述します。なぜ今ガバナンスが必要なのか、世界のルールはどうなっているのか、そして企業は具体的にどう動くべきか。本稿が、AI時代の荒波を乗り越える羅針盤となることを目指します。

第1章:なぜ今、「AIガバナンス」なのか?

1-1. AIガバナンスの定義

「AIガバナンス」という言葉を聞くと、多くの人は厳格なルール作りや、禁止事項のリスト化といった「管理・統制」をイメージするかもしれません。しかし、それはガバナンスの一側面に過ぎません。 真のAIガバナンスとは、「AIのリスクを適切に管理しながら、AIの恩恵を最大限に享受するための仕組みづくり」を指します。つまり、ブレーキ(リスク管理)だけでなく、アクセル(活用推進)を安全に踏み込むための環境整備が含まれます。

具体的には、AIを利用する際の方針(ポリシー)の策定、組織体制の構築、開発・運用プロセスの整備、そしてそれらが正しく機能しているかを監視・評価する一連のシステムです。これらが整備されて初めて、現場の社員は迷いや不安なく、イノベーションに向けてAIを積極的に活用できるようになります。AIガバナンスは、イノベーションを阻害するものではなく、イノベーションを「加速」させるための土台なのです。

1-2. 必要とされる社会的背景

なぜ今、これほどまでにAIガバナンスが叫ばれるのでしょうか。その背景には、AI特有の性質と、過去の教訓があります。

第一に、現在の主流であるディープラーニングを用いたAIには、「ブラックボックス問題」が存在します。AIがなぜそのような結論を出したのか、その思考プロセスが人間には理解しにくいのです。理由のわからない判断に基づいてビジネスを行うことは、説明責任の観点から大きなリスクとなります。

第二に、過去に起きた数々の失敗事例が、社会の警戒心を高めている点です。 例えば、ある大手IT企業が開発した採用AIは、過去のデータを学習した結果、「女性」という単語が含まれる履歴書の評価を下げるようになってしまい、運用停止に追い込まれました。 また、SNS上で学習を続けたチャットボットが、短期間のうちに差別的な発言や暴言を繰り返すようになり、公開停止となった事例も有名です。 さらに、画像生成AIが特定のアーティストの画風を模倣した作品を大量に生成し、法的な争いに発展したケースもあります。

これらの事例は、「悪意がなくても、AIが差別や権利侵害を引き起こす可能性がある」ことを示しています。社会は今、企業に対し「便利なAIを使ってもいいが、その結果に対して責任を持てるのか?」と厳しく問いかけています。この問いに答えるのが、ガバナンスです。

1-3. 企業における「守り」と「攻め」の両立

AIガバナンスには、「守り」と「攻め」の二つの側面があります。

「守りのガバナンス」は、法的リスクやレピュテーション(評判)リスクの回避です。 AIによる差別や誤情報の拡散、プライバシー侵害は、訴訟問題に発展するだけでなく、ブランドイメージを修復不可能なほどに毀損します。特にSNS時代において、企業の不祥事は瞬く間に世界中に拡散します。「AIが勝手にやったこと」という言い訳は通用しません。堅牢なガバナンス体制を敷くことは、企業存続のための防波堤となります。

一方で、「攻めのガバナンス」は、社会からの信頼獲得による競争優位性の確立です。 「この会社のAIサービスなら安心して使える」「この企業はデータを倫理的に扱っている」という信頼(トラスト)は、AI時代における最強のブランド資産となります。 顧客や取引先は、機能の優劣だけでなく、その背後にある企業の姿勢を見て選ぶようになっています。適切なガバナンスをアピールすることで、他社との差別化を図り、より多くの良質なデータを集め、さらに良いAIサービスを作るという正のループを生み出すことができます。 つまり、AIガバナンスへの投資は、単なるコストではなく、将来の収益を生み出すための戦略的投資なのです。

第2章:AIガバナンスの主な目的と原則

2-1. 国際的な原則の潮流

AIガバナンスを構築する際、ゼロからルールを作る必要はありません。世界中で議論されている共通の「原則」が存在するからです。OE...

今、ビジネスの現場では「AIを使わない」という選択肢が消えつつあります。業務効率化から新規事業の創出まで、AIは企業の成長エンジンそのものになり得るからです。しかし、強力なエンジンには、それを制御する高度なハンドルとブレーキが必要です。それが「AIガバナンス」です。今回は、AI活用を単なるブームで終わらせず、企業が永続的に成長するための生存戦略として、ガバナンスの構築から最新の法規制対応までを網羅的に解説します。

序文:AIの進化と「待ったなし」の課題

1. 生成AIの爆発的普及と社会へのインパクト

かつてSFの世界の話であった人工知能(AI)は、ディープラーニングの進化を経て、今や私たちの日常業務に深く浸透しました。特に2022年以降の生成AI(Generative AI)の登場は、産業革命にも匹敵するパラダイムシフトをもたらしています。 これまでのAIがデータの「分析・分類」を得意としていたのに対し、生成AIは文章、画像、プログラムコードなど、新しい価値を「創造」することができます。これにより、マーケティング資料の作成、顧客対応の自動化、新製品のアイデア出しなど、ホワイトカラーの業務領域において劇的な生産性向上が実現しつつあります。企業にとってAI活用は、もはや「あれば便利」なツールではなく、競争力を左右する「経営資源」そのものとなったのです。

2. 利便性の裏に潜むリスク

しかし、光が強ければ影もまた濃くなります。AIの急速な普及は、企業に予期せぬリスクをもたらしました。 最も代表的なのが「ハルシネーション(幻覚)」と呼ばれる現象です。AIがもっともらしい嘘をつくこの現象は、誤った経営判断や顧客への誤情報の提供につながる恐れがあります。 また、学習データに含まれる偏見がAIに継承されることによる「差別」の問題も深刻です。採用AIが特定の人種や性別を不利に扱ったり、融資審査で不当な判定を下したりする事例は、世界中で報告されています。 さらに、生成AIが既存の著作物を学習・出力することによる「著作権侵害」のリスクや、機密情報がAIを通じて外部に流出するセキュリティリスクも無視できません。これらは単なる技術的なエラーではなく、企業の社会的信用を一瞬で失墜させる経営リスクなのです。

3. リスクを制御し、AIの価値を最大化する道筋を示す

これらのリスクを恐れてAIの利用を禁止することは、企業の成長機会を放棄することと同義です。重要なのは、リスクをゼロにすることではなく、許容可能な範囲にコントロールしながら、AIの価値を最大化することです。 本稿では、AIのリスクを適切に管理し、社会から信頼される企業となるための枠組みである「AIガバナンス」について詳述します。なぜ今ガバナンスが必要なのか、世界のルールはどうなっているのか、そして企業は具体的にどう動くべきか。本稿が、AI時代の荒波を乗り越える羅針盤となることを目指します。

第1章:なぜ今、「AIガバナンス」なのか?

1-1. AIガバナンスの定義

「AIガバナンス」という言葉を聞くと、多くの人は厳格なルール作りや、禁止事項のリスト化といった「管理・統制」をイメージするかもしれません。しかし、それはガバナンスの一側面に過ぎません。 真のAIガバナンスとは、「AIのリスクを適切に管理しながら、AIの恩恵を最大限に享受するための仕組みづくり」を指します。つまり、ブレーキ(リスク管理)だけでなく、アクセル(活用推進)を安全に踏み込むための環境整備が含まれます。

具体的には、AIを利用する際の方針(ポリシー)の策定、組織体制の構築、開発・運用プロセスの整備、そしてそれらが正しく機能しているかを監視・評価する一連のシステムです。これらが整備されて初めて、現場の社員は迷いや不安なく、イノベーションに向けてAIを積極的に活用できるようになります。AIガバナンスは、イノベーションを阻害するものではなく、イノベーションを「加速」させるための土台なのです。

1-2. 必要とされる社会的背景

なぜ今、これほどまでにAIガバナンスが叫ばれるのでしょうか。その背景には、AI特有の性質と、過去の教訓があります。

第一に、現在の主流であるディープラーニングを用いたAIには、「ブラックボックス問題」が存在します。AIがなぜそのような結論を出したのか、その思考プロセスが人間には理解しにくいのです。理由のわからない判断に基づいてビジネスを行うことは、説明責任の観点から大きなリスクとなります。

第二に、過去に起きた数々の失敗事例が、社会の警戒心を高めている点です。 例えば、ある大手IT企業が開発した採用AIは、過去のデータを学習した結果、「女性」という単語が含まれる履歴書の評価を下げるようになってしまい、運用停止に追い込まれました。 また、SNS上で学習を続けたチャットボットが、短期間のうちに差別的な発言や暴言を繰り返すようになり、公開停止となった事例も有名です。 さらに、画像生成AIが特定のアーティストの画風を模倣した作品を大量に生成し、法的な争いに発展したケースもあります。

これらの事例は、「悪意がなくても、AIが差別や権利侵害を引き起こす可能性がある」ことを示しています。社会は今、企業に対し「便利なAIを使ってもいいが、その結果に対して責任を持てるのか?」と厳しく問いかけています。この問いに答えるのが、ガバナンスです。

1-3. 企業における「守り」と「攻め」の両立

AIガバナンスには、「守り」と「攻め」の二つの側面があります。

「守りのガバナンス」は、法的リスクやレピュテーション(評判)リスクの回避です。 AIによる差別や誤情報の拡散、プライバシー侵害は、訴訟問題に発展するだけでなく、ブランドイメージを修復不可能なほどに毀損します。特にSNS時代において、企業の不祥事は瞬く間に世界中に拡散します。「AIが勝手にやったこと」という言い訳は通用しません。堅牢なガバナンス体制を敷くことは、企業存続のための防波堤となります。

一方で、「攻めのガバナンス」は、社会からの信頼獲得による競争優位性の確立です。 「この会社のAIサービスなら安心して使える」「この企業はデータを倫理的に扱っている」という信頼(トラスト)は、AI時代における最強のブランド資産となります。 顧客や取引先は、機能の優劣だけでなく、その背後にある企業の姿勢を見て選ぶようになっています。適切なガバナンスをアピールすることで、他社との差別化を図り、より多くの良質なデータを集め、さらに良いAIサービスを作るという正のループを生み出すことができます。 つまり、AIガバナンスへの投資は、単なるコストではなく、将来の収益を生み出すための戦略的投資なのです。

第2章:AIガバナンスの主な目的と原則

2-1. 国際的な原則の潮流

AIガバナンスを構築する際、ゼロからルールを作る必要はありません。世界中で議論されている共通の「原則」が存在するからです。OECD(経済協力開発機構)やG7などが提唱するAI原則には、いくつかの共通項があります。

最も重要なのが「人間中心(Human-centric)」の考え方です。AIはあくまで人間の幸福や社会の発展のために使われるべき道具であり、人間の尊厳や自律性を脅かしてはならないという基本理念です。 この理念を支える柱として、以下の要素が求められます。

- 公平性(Fairness): 性別、人種、年齢などによる不当な差別を行わないこと。

- 説明責任(Accountability): AIの動作や結果に対し、開発・提供者が責任を持つこと。

- 透明性(Transparency): AIがいつ、どこで、どのように使われているか、なぜその判断に至ったかが分かること。

- 安全性(Safety): 人間に危害を加えず、意図通りに動作すること。

- プライバシー保護: 個人のデータを適正に扱い、権利を侵害しないこと。

企業が自社のAIポリシーを策定する際は、これらの国際的な潮流を踏まえていることが、グローバルビジネスを展開する上での前提条件となります。

2-2. リスクベース・アプローチとは

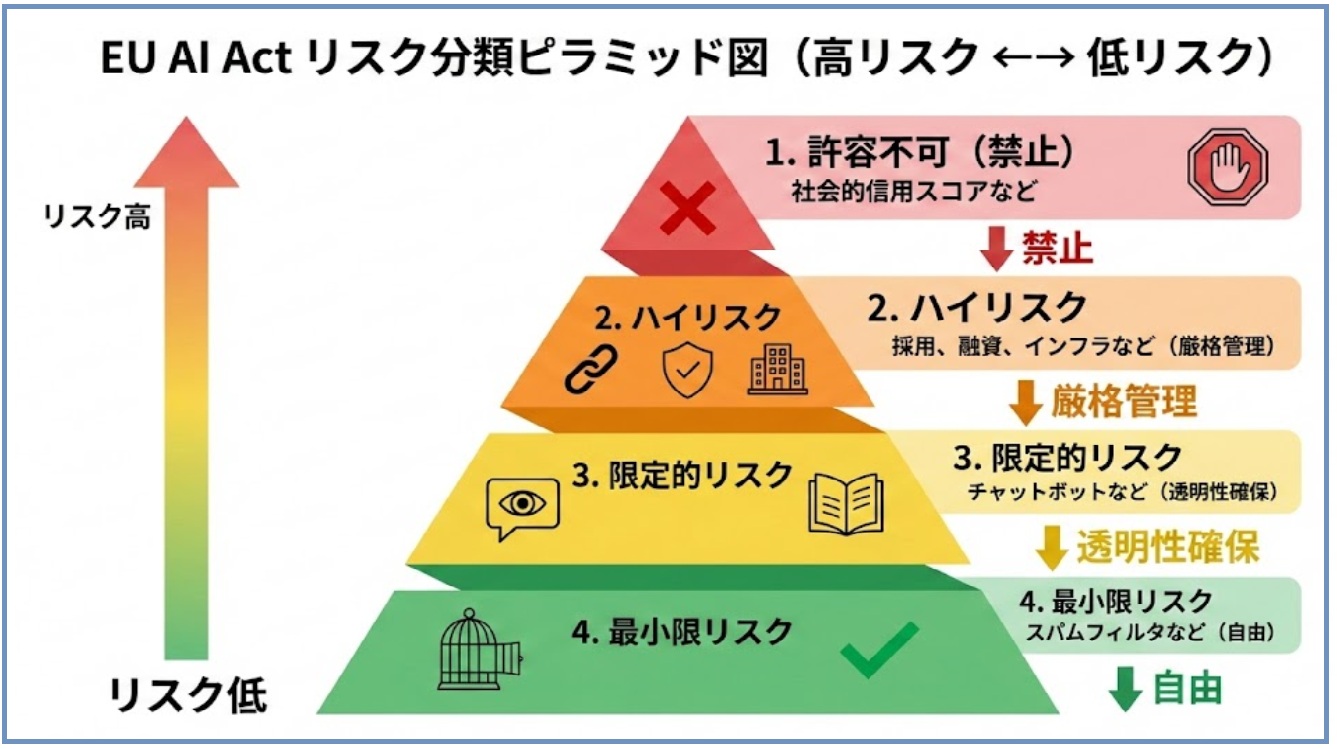

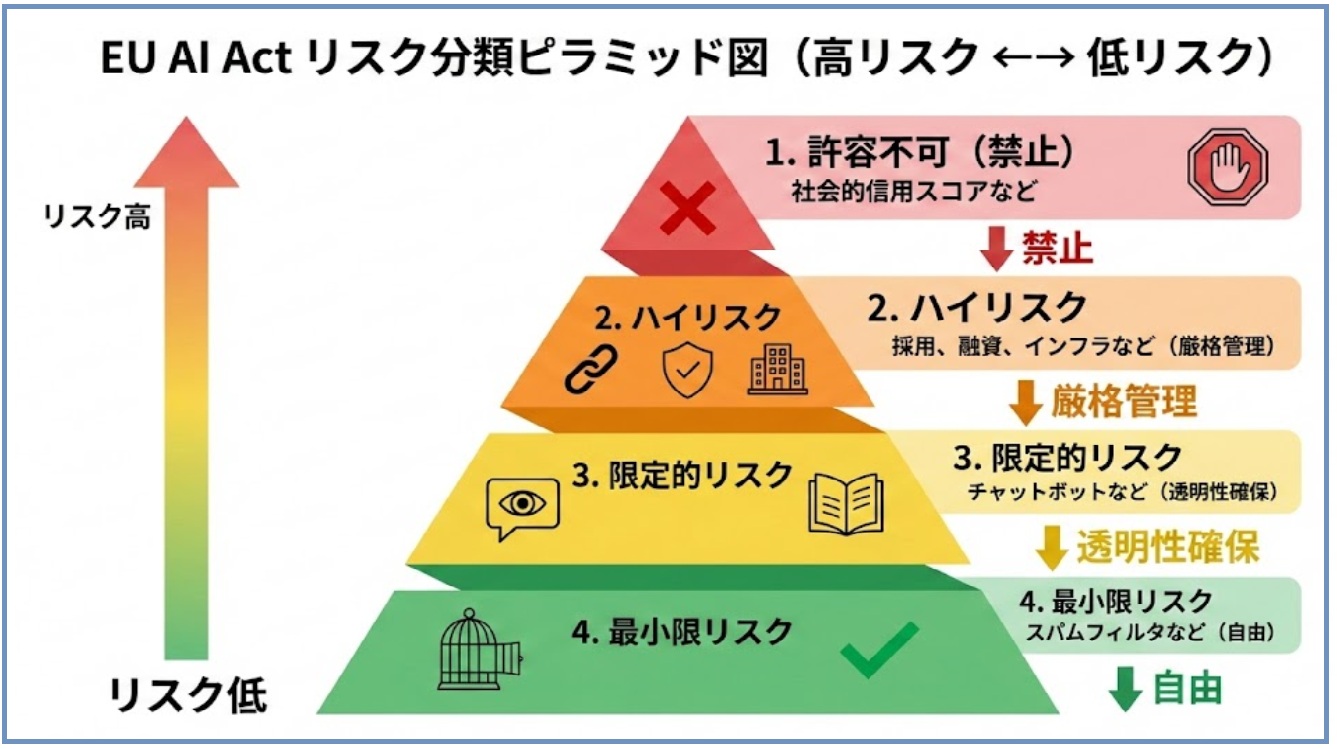

AIガバナンスの実践において極めて重要な概念が「リスクベース・アプローチ」です。これは、「全てのAIを一律に厳しく管理するのではなく、AIの使用目的や影響度に応じて管理レベルを変える」という考え方です。

例えば、社内のランチメニューを提案するチャットボットと、自動運転車を制御するAI、あるいは人間の採用可否を判断するAIでは、誤作動が起きた時のリスクの大きさが全く異なります。 ランチの提案を間違えても笑い話で済みますが、自動運転や採用判断のミスは、人命や人の一生に関わります。

リスクが高い領域(ハイリスク)には、厳格なテスト、人間の監視、詳細な記録保存などの重いガバナンスを適用します。 一方で、リスクが低い領域には、最低限のルールで自由な活用を促します。 すべてをガチガチに管理してしまうと、現場の萎縮を招き、DX(デジタルトランスフォーメーション)のスピードを殺してしまいます。リスクの大きさを正しくアセスメント(評価)し、メリハリのある管理を行うことが、実効性のあるガバナンスの鍵です。EU AI法案などで採用されているリスク分類は、以下のピラミッド図で理解すると分かりやすいです。

図. EU AI Act リスク分類

2-3. ステークホルダーへの責任

AIガバナンスは、誰のためにあるのでしょうか。それは企業を取り巻く全てのステークホルダーのためです。

- 顧客に対して: 安全で信頼できるサービスを提供する責任があります。「なぜローン審査に落ちたのか」「この商品はなぜおすすめされたのか」といった疑問に対し、可能な限り説明できる体制が必要です。また、生成AIを利用している場合は、それが「AIによって生成されたものである」と明示することも、消費者の誤認を防ぐための重要な責任です。

- 従業員に対して: AI導入によって雇用が脅かされるのではないか、という不安に寄り添う必要があります。また、従業員が意図せずAIを使って違法行為をしてしまわないよう、教育やガイドラインによって守ることも企業の責任です。「AIの使い方を知らなかった」ことで従業員個人が責められる事態は避けなければなりません。

- 株主・投資家に対して: AIリスクが適切に管理されていることを示し、企業価値の毀損を防ぐ姿勢を示す必要があります。ESG投資(環境・社会・ガバナンス)の文脈においても、AI倫理への取り組みは重要な評価指標となりつつあります。

- 社会全体に対して: 民主主義や社会的公正を揺るがすようなAI利用(フェイクニュースの拡散や監視社会化など)に加担しないという倫理観が求められます。

このように、AIガバナンスは単なる社内規定ではなく、企業が社会の一員として果たすべき広範な責任の表明なのです。

第3章:世界の法規制とガイドラインの動向

3-1. 欧州(EU)の動向:世界初の包括的規制「EU AI法案」

AI規制において世界をリードしているのが欧州連合(EU)です。EUは「信頼できるAI」の確立を目指し、世界初となる包括的な法的枠組み「EU AI法案(AI Act)」を成立させました。 この法律の最大の特徴は、前述のリスクベース・アプローチを法的義務として厳格に適用する点です。AIのリスクを以下の4段階に分類しています。

- 許容できないリスク(禁止): 人間の潜在意識を操作するAIや、公的機関による社会的信用スコアリングなど。これらは開発・使用が完全に禁止されます。

- ハイリスク: 重要インフラ、教育、雇用、法執行などに関わるAI。これらには、高品質なデータ管理、詳細な技術文書の作成、人間による監視、高い精度の確保などが法的に義務付けられます。違反した場合、巨額の制裁金が科される可能性があります。

- 限定的リスク: チャットボットやディープフェイクなど。これらには、AIであることを利用者に知らせる「透明性義務」が課されます。

- 最小限のリスク: 迷惑メールフィルターやゲーム内AIなど。特段の規制はありません。

EU市場でビジネスを行う企業にとって、この法律への対応は必須です。また、GDPR(一般データ保護規則)が世界標準になったように、このAI法案も世界の規制のデファクトスタンダードになる可能性が高く、日本企業も無視できません。

3-2. 米国の動向:大統領令と自律的なガイドライン

イノベーションの震源地である米国は、伝統的に企業の自主性を尊重してきましたが、近年はAIのリスク管理に積極的な姿勢を見せています。 バイデン政権による「AIに関する大統領令」では、安全性テストの結果報告を開発企業に義務付けるなど、国家安全保障の観点からの規制強化が進んでいます。

一方で、企業実務において重要な基準となっているのが、NIST(米国国立標準技術研究所)が発行した「AIリスクマネジメントフレームワーク(AI RMF)」です。これは法律ではありませんが、AIのリスクを特定・測定・管理するための実践的なガイドラインとして、世界中の企業で参照されています。 「ガバナンス(統治)」「マップ(特定)」「メジャー(測定)」「マネージ(管理)」の4つの機能を行き来しながら、継続的にリスクを低減させていくプロセスが示されており、企業の自主的な取り組みを支援するツールとして機能しています。

3-3. 日本の動向:法規制とガイドラインのハイブリッド

日本は、イノベーションを阻害しないよう、ハードロー(法律)による厳しい規制よりも、ソフトロー(ガイドライン)による自主規制を重視するアプローチをとっています。

経済産業省や総務省が中心となって策定した「AI事業者ガイドライン」がその中核です。これは、AI開発者、提供者、利用者それぞれの立場で取り組むべき事項を整理したもので、法的拘束力はないものの、日本企業が準拠すべき事実上の標準となっています。 このガイドラインでは、人間の尊厳、公平性、プライバシーなどの原則に加え、各主体がステークホルダーと対話しながらリスク管理を行うことが求められています。

また、日本独自の論点として「著作権法」があります。日本の著作権法は、AI開発のための情報解析(学習)に対して比較的寛容であるとされていますが(第30条の4)、生成されたコンテンツの利用段階では通常の著作権侵害のリスクが存在します。文化庁などが示す解釈指針を注視し、学習段階と利用段階を分けてリスクを判断することが重要です。 日本企業は、これらガイドラインを遵守しつつ、EUなどの海外規制にも対応できる「二階建て」のガバナンス体制を構築する必要があります。

第4章:企業が実施できる具体的取り組み

4-1. ガバナンス体制の構築(組織・人)

AIガバナンスを絵に描いた餅にしないためには、明確な責任所在と組織体制が必要です。

まず検討すべきは、「AI倫理委員会」や「AIガバナンス委員会」の設置です。これは、AI開発や導入における重要な意思決定を行う機関です。 メンバーには、開発部門や事業部門だけでなく、法務、リスク管理、人事、広報などの部門を横断的に参加させることが重要です。さらに、客観性を担保するために、外部の有識者(弁護士や倫理学者)を招聘する企業も増えています。技術的な視点だけでなく、倫理的・社会的視点から多角的に議論できる場を作ることが目的です。

また、責任者(オーナー)を明確にすることも不可欠です。CDO(最高デジタル責任者)がAI推進とガバナンスの両方を統括するケースもあれば、牽制機能を働かせるために、CRO(最高リスク管理責任者)やCPO(個人情報保護責任者)がガバナンスを担うケースもあります。重要なのは、経営トップが関与し、AIガバナンスが経営課題であることを組織全体に示すことです。

4-2. ルールとプロセスの策定(運用)

組織ができたら、次は具体的なルールとプロセスを策定します。

・社内AI利用ガイドラインの策定

「入力してはいけないデータ(個人情報、機密情報など)」「生成物の取り扱い(そのまま対外的に出してよいか)」「禁止される用途」などを具体的に定めます。特に生成AIに関しては、全社員が理解できる平易な言葉で、禁止事項と推奨事項を明記したガイドラインを配付することが急務です。

・開発・導入・運用各フェーズでのチェックリスト活用

AIのライフサイクルに沿ったチェック体制を構築します。

- 企画段階: そのAI活用は倫理的に問題ないか?利用目的は明確か?

- 開発・学習段階: 学習データに偏りはないか?著作権処理は適切か?

- 導入前検証: 意図しない挙動はないか?精度の劣化はないか?

- 運用段階: 継続的にモニタリングされているか?ユーザーからの苦情窓口はあるか?

これらを網羅したチェックリストを作成し、ゲート(関所)を設けることで、リスクの見落としを防ぎます。特に外部ベンダーからAI製品を導入する場合も、ベンダー任せにせず、自社の基準でチェックを行う調達基準の整備が必要です。以下のようなチェックリストを開発フローに組み込むことを推奨します。

- [ ] 学習データ: 権利クリアランスは済んでいるか?偏りはないか?

- [ ] モデル検証: 差別的な出力やハルシネーションを確認したか?

- [ ] 透明性: ユーザーに「AIであること」を明示しているか?

4-3. 技術的アプローチ(技術)

精神論やルールだけでなく、技術的な仕組みでガバナンスを担保することも重要です。

・MLOps(機械学習基盤)によるモニタリング

AIモデルは一度作ったら終わりではありません。AIモデルは生鮮食品のようなもので、時間が経つと鮮度が落ちます(ドリフト現象)。例えば、コロナ禍前後のデータでは消費者の行動パターンが全く違うため、AIの予測が当たらなくなるのです。これを防ぐのがMLOpsによる常時監視です。MLOps(Machine Learning Operations)の仕組みを導入し、モデルの精度や挙動を常時監視し、異常があればアラートを出し、再学習のサイクルを回す環境を整えます。

・公平性・バイアス検知ツールの導入

AIの判断に偏りがないかを検証するためのツール活用も有効です。例えば、特定の属性に対して不利な結果が出ていないかを統計的に分析するライブラリや、生成AIの出力に含まれる有害表現を自動フィルタリングするガードレール機能などをシステムに組み込みます。 また、説明可能性(XAI)を高める技術を採用し、AIがなぜその答えを出したのかをある程度可視化できるようにしておくことも、信頼性向上のために重要です。

4-4. 人材教育とリテラシー向上

最も重要な防御ラインは、AIを使う「人」です。どんなに立派なルールがあっても、社員がそれを知らなければ意味がありません。

・全社員向けのリスク教育

「なぜ機密情報をチャットボットに入力してはいけないのか」「AIの回答を鵜呑みにすることがなぜ危険なのか」といった基本リテラシー教育を全社員に行います。eラーニングなどを活用し、定期的に知識をアップデートすることが必要です。

・プロンプトエンジニアリングと倫理研修

AIを使いこなすための「プロンプトエンジニアリング」研修の中に、倫理的な視点を組み込みます。意図せず差別的な出力を誘導してしまわないような入力の仕方や、生成物の真偽を確認(ファクトチェック)するスキルの習得を促します。 「AIガバナンスは管理部門の仕事」ではなく、「AIを使う全ての社員の責務」という文化を醸成することが、最終的には最も強いガバナンスとなります。

第5章:先進企業の取り組み事例

事例1:金融・保険業界における公平性の担保

ある大手金融機関では、AIを活用した融資審査モデルを導入するにあたり、徹底した「説明可能性」の追求を行いました。 従来、AIによる与信判断はブラックボックス化しやすく、「総合的な判断」として顧客に理由を説明できないケースがありました。しかし、この企業では、AIが弾き出したスコアに対して、「どの項目がプラス・マイナスに影響したか」を明示できるモデル(XAI技術)を採用しました。 さらに、開発段階で過去のデータを検証し、性別や居住地域による不当なバイアスがかかっていないかを第三者機関も含めて監査しました。この結果、審査スピードを劇的に向上させつつ、顧客からの納得感と信頼を勝ち取ることに成功しています。

事例2:製造業・IT企業における品質管理

あるグローバル製造業では、社内の技術文書やノウハウを検索・要約する生成AIシステムを構築しました。 ここでは「ハルシネーション対策」として、RAG(Retrieval-Augmented Generation)という技術を採用しました。ハルシネーション(嘘)を防ぐ「RAG」技術は、生成AIに「社内規定」や「マニュアル」といったカンニングペーパー(外部知識)を渡して回答させるRAG技術を導入することです。これにより、「AIが勝手なことを言わない」環境を作り、業務利用の安全性を担保しました。AIに知識だけで答えさせるのではなく、必ず社内の信頼できるデータベースを参照させ、その出典元(根拠)を回答と一緒に表示させる仕組みです。 また、出力結果に対する「Good/Bad」のフィードバック機能を実装し、現場のエンジニアが回答の品質を評価することで、継続的に精度を向上させるプロセス(Human-in-the-loop)を確立しました。これにより、熟練技術者の知見継承と業務効率化を安全に進めることが可能になりました。

おわりに:信頼されるAI社会の構築に向けて

AIガバナンスは、決して企業の足を引っ張る「ブレーキ」ではありません。むしろ、F1マシンのような高性能なAIというエンジンを、トップスピードで、かつ安全にハンドリングするための不可欠な機能です。 法規制への対応は重要ですが、それはあくまで最低限の基準(ベースライン)に過ぎません。企業に求められているのは、「法律さえ守ればよい」という受動的な態度ではなく、「私たちはAIをこのように責任を持って使い、社会に貢献する」という主体的な意志の表明です。

AI技術は日進月歩で進化し、法規制もまた刻々と変化します。固定的なルールを作って終わりにするのではなく、変化に合わせて柔軟にガバナンスを進化させていく「アジャイル・ガバナンス」の姿勢が求められます。 人とAIが共存し、豊かさを享受できる未来を作れるかどうかは、今、私たちがどうAIと向き合い、どう統治していくかにかかっています。AIガバナンスへの真摯な取り組みこそが、不確実なAI時代を生き抜くための、最強の生存戦略となるでしょう。